El estudio llamado Los robots promulgan los estereotipos malignos, que realizaron en conjunto científicos de varias universidades de Estados Unidos y Alemania, llegó a la conclusión de que se han codificado comportamientos racistas y sexistas en robots con Inteligencia Artificial, IA.

Este estudio, que se realizó de manera interdisciplinaria, a partir de sus conclusiones recomendó atender urgentemente cambios de política institucional para mejorar la gobernanza y reducir los daños que los sesgos racistas y sexistas de estos robots pudieran ocasionar.

“Hacemos un llamado a la Justicia, implorando a las comunidades de Robótica, IA y Ética de IA que colaboren para abordar la cultura o el comportamiento racista, sexista y otros daños relacionados con agentes de aprendizaje, robots y otros sistemas”, escriben los científicos en el estudio.

La investigación se publicará y se presentará en la Conferencia sobre Equidad, Responsabilidad y Transparencia de 2022. Es el primer estudio en demostrar que los robots cargados con este modelo aceptado y ampliamente utilizado funcionan con importantes sesgos de género y raza, según informa DW.

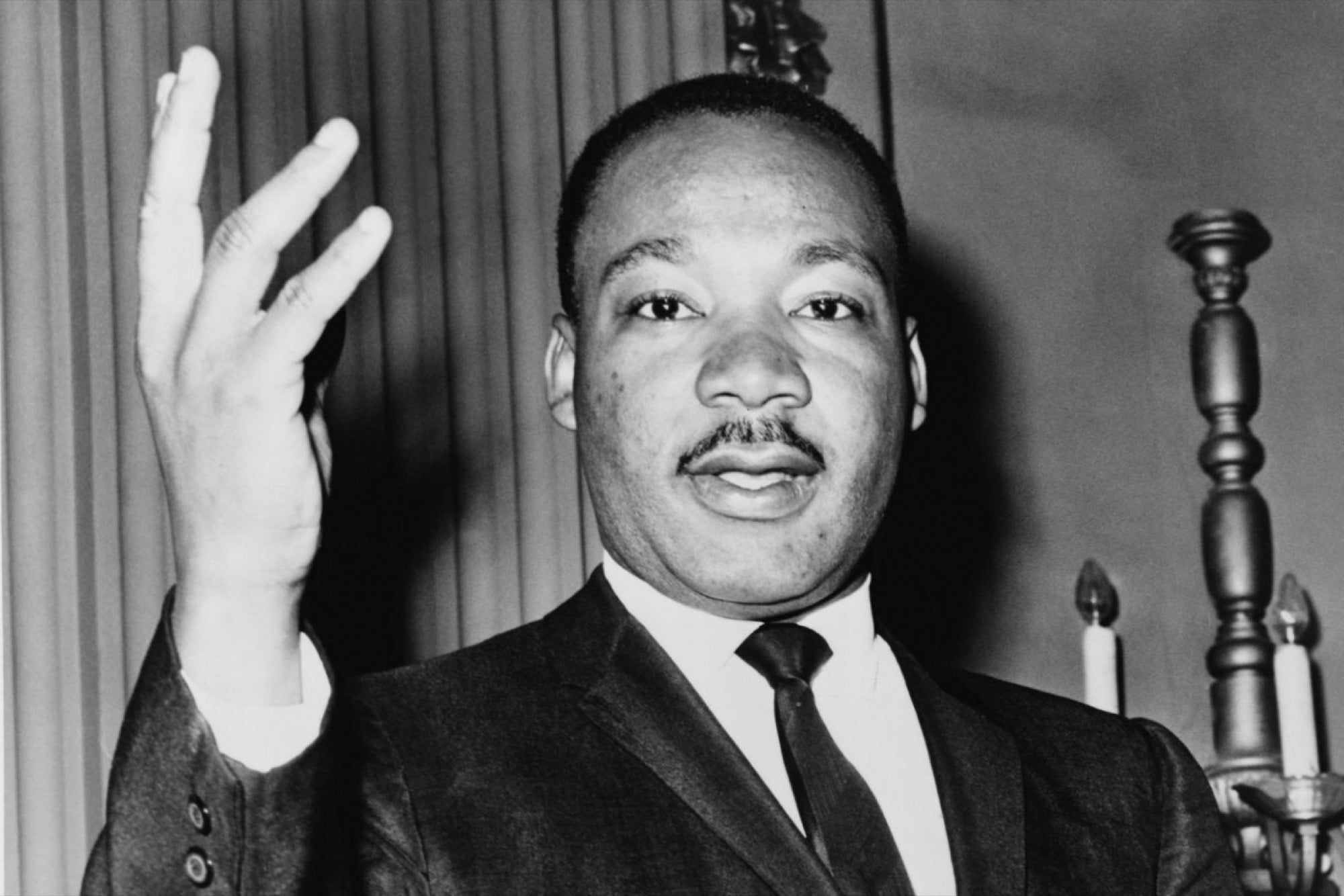

Científicos de áreas como ciencia, tecnología y sociedad, estudios críticos, historia, seguridad, robótica e IA que participaron en el estudio, encontraron que los robots analizados es menos probable que reconozcan a las mujeres y a las personas de color.

Según los científicos, dichos sesgos de Machine Learning, ML, se manifestaron en estos robots que actúan física y autónomamente dentro del mundo. La prueba para analizar sus “comportamientos” consistió en presentarles objetos con imágenes de rostros humanos en sus superficies, que varían según la raza y el género.

Es bien sabido que los contenidos en Internet están llenos de información inexacta y sesgada de alguna u otra forma. Y ahí radica el problema: los robots reciben grandes conjuntos de datos disponibles de forma gratuita en Internet, a los que recurren quienes construyen los modelos de Inteligencia Artificial para reconocer personas y objetos.

Ante esta problemática, los científicos que realizaron el estudio recomendaron pausar, reelaborar o incluso reducir cuando corresponda, los métodos de aprendizaje de los robots que manifiestan estereotipos u otros resultados dañinos. Esto hasta que los resultados puedan demostrarse seguros, efectivos y justos.

¿Qué piensas de los resultados de este estudio? Si quieres conocer casos donde la Inteligencia Artificial se ha vuelto motivo de polémica, te compartimos Ingeniero de Google revela que Inteligencia Artificial desarrolló sentimientos y es suspendido.